2025年科研成果-论文年度总结

黑料不打烊

今年共发表了9篇文献,横跨语言神经机制、语言与认知发展、语言习得与教育、语音情感识别领域,探索大脑与语言的奥秘。AI 帮我们把这些研究捋一捋、扯扯闲篇儿!全程直白不绕弯,绝对听着不无聊、越听越入迷~

一、语言神经机制(Neural mechanisms underlying language processing)

张文嘉,董洁,冯根义,王刚,古宗文,高旭,刘馨怡,燕浩*(2025). The neural mechanisms underlying semantic unification and semanteme integration. Brain and Language, 269, 105629.(SSCI JCR Q1)

注:这张图就像“大脑的语言加工竞赛现场直播”——左边是“语义整合”赛道,只有右侧颞叶前部(RATL)在默默干活,右边是“义素整合”赛道,却是“全脑总动员”:颞叶前部、颞叶后部、角回、额下回……全都亮了起来。

比较大脑干两种“拼意思”的活儿:一是常见的语义整合(把“吃”和“药”拼成“吃药”),二是不常用的义素整合(把“男性”“长辈”拼成“父亲”)。结果发现,“造字”这种精细活可比“组词”费脑多了!它得召集更多脑区(比如右侧颞叶前部、角回)开“联合会议”,脑区之间的“电话线”也忙到发热。看来对付非常规任务,大脑也得搞跨部门协作才行。

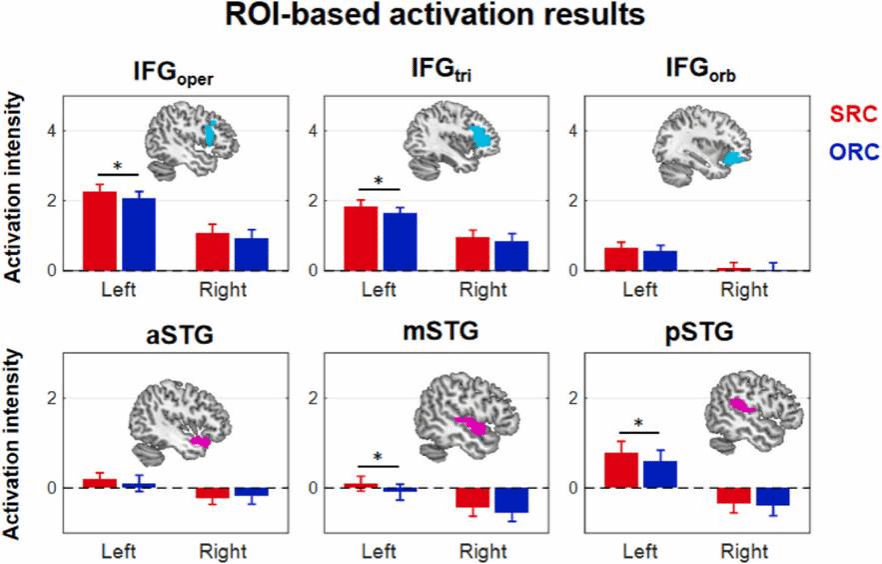

张文嘉,闫志强,董洁,刘馨怡,郑奥科,梁红,燕浩*(2025). The nature of syntactic working memory during relative clause processing: fMRI evidence from multiple anatomic ROIs. Neuropsychologia, 211, 109107.( SCIE 中科院Q3)

注:这是大脑的“工作强度指示器”:红色(主语从句)让左脑前额叶和颞叶多个子区域“加班”点亮;蓝色(宾语从句)则让它们轻松不少。大脑处理复杂句子时,就像同时开了“语言专属”和“通用内存”两个后台程序,忙得不亦乐乎。

想搞懂大脑处理套娃句子(比如“那个昨天撞了你的司机”)时,用的“句法工作内存”是公用的还是语言私有的?结果发现汉语里有个反直觉现象:宾语从句(像“富豪勾结的法官”)反而比主语从句(像“勾结富豪的法官”)更好懂!因为汉语中心语后置的特点,把中心语(“法官”)和动词(“勾结”)扯得太远,大脑“内存条”直接告急。fMRI扫描显示,左脑前额叶两块区域——管通用记忆的背侧和管语言特需的腹侧——同时忙到飞起。看来这“内存”是公私合营的,既干粗活也搞专业!

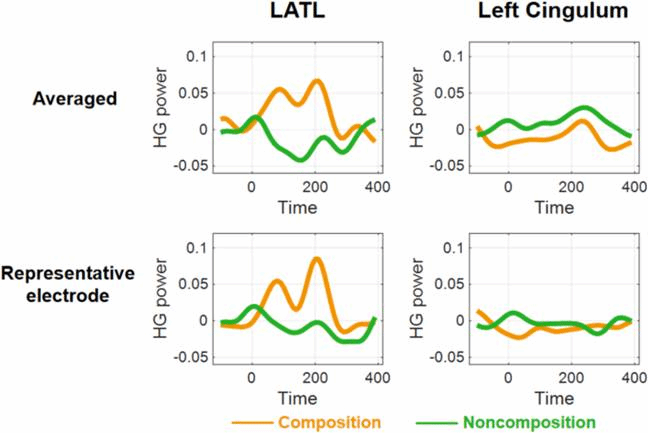

闫志强,张文嘉,董秋峰,董洁,黄莹颖,蒋晓帆,燕浩*(2025). The role of left anterior temporal lobe in basic linguistic composition: Evidence from stereo-electroencephalography. Neuroscience, 569, 155-160.(SCIE 中科院 Q4)

注:左前颞叶是处理视觉模态短语语义整合的关键脑区,且该处理过程在词汇呈现后约125毫秒达到高峰。

想看看左侧颞叶前部(LATL)在组合两个词(比如“红船”)时是不是真在干活?之前用脑磁图(MEG)看“读”词时它挺活跃,但用颅内电极(iEEG)听“听”词时它却“装睡”。这回研究者直接让癫痫患者用iEEG“读”词,结果抓了个正着:LATL在整合词汇语义时(约125毫秒)高频伽马波明显更强!看来这个脑区确实是个“组合器”,但它的表现可能取决于你是“看”还是“听”指令。这提示刺激模态(视觉vs听觉)可能是关键,未来得让iEEG也比比“视听差异”。

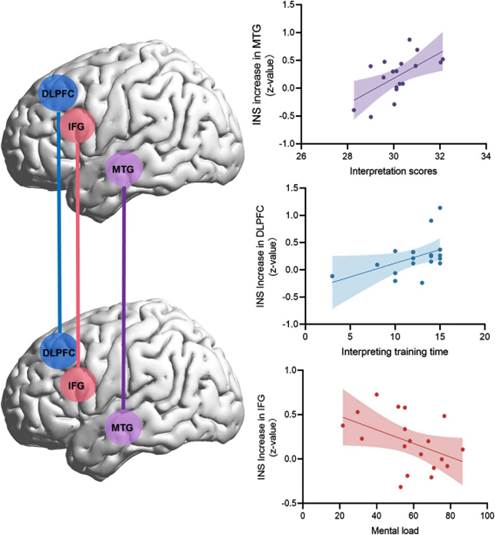

张艺,段绪,冯延琴,梁渊,黄莹颖,燕浩*(2025). Interpersonal neural synchronization in frontal-temporal regions as new neurophysiological index of interpretation quality: an fNIRS hyperscanning study. Language, Cognition and Neuroscience, 40(2), 165-176.(SSCI JCR Q1)

注:这仨脑区堪称 “口译打工人天团”:口译分越高,MTG的INS越高;练得越久,DLPFC 的 “干劲值” 越飙,是工龄越长越靠谱的老黄牛;就 IFG 玻璃心,心理压力一上来直接摆烂,INS 唰唰往下掉 —— 主打一个 “压力大了干不动”。

文献实锤口译相关脑区的 “小脾气”:口译分数越高,左MTG的INS越给力;训练时长越久,左DLPFC的同步性越在线;心理负荷一超标,左IFG的INS 直接 “躺平”,这神经同步规律藏都藏不住~

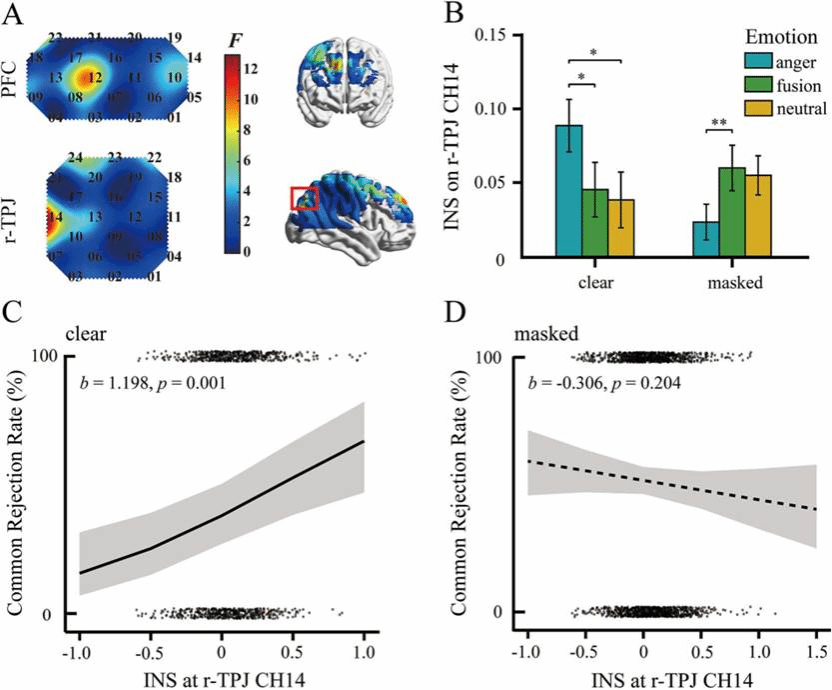

王旭东,葛猷勋,应奎林,昌颖超,罗杨眉,燕浩*,陈煦海* (2025).Anger expression facilitates social punishment and neural synchrony in collective unfairness. Cerebral Cortex, 35(7), bhaf185. (SCI, 中科院Q2)

注:先给大脑 “地图” 标好关键位置—— 右侧颞顶联合区(r-TPJ)(图 A)。等清晰甩愤怒脸时,它的 “脑电波同步值”(INS)直接飙高(图 B);表情明明白白的话,这同步值还能预判 “集体拒绝率”,但表情一被挡,这预判技能直接失灵(图 C-D)。

这波研究把 “愤怒的力量” 玩明白了!用 fNIRS + 三人最后通牒游戏实测,清晰的愤怒表达直接让集体惩罚值拉满,右侧颞顶联合区的大脑同步还 “开挂” 上涨,甚至能预判拒绝率;可一旦表情被遮,这波 “愤怒 buff” 直接掉线,效果大打折扣~

二、语言与认知发展(Language and Cognitive Development)

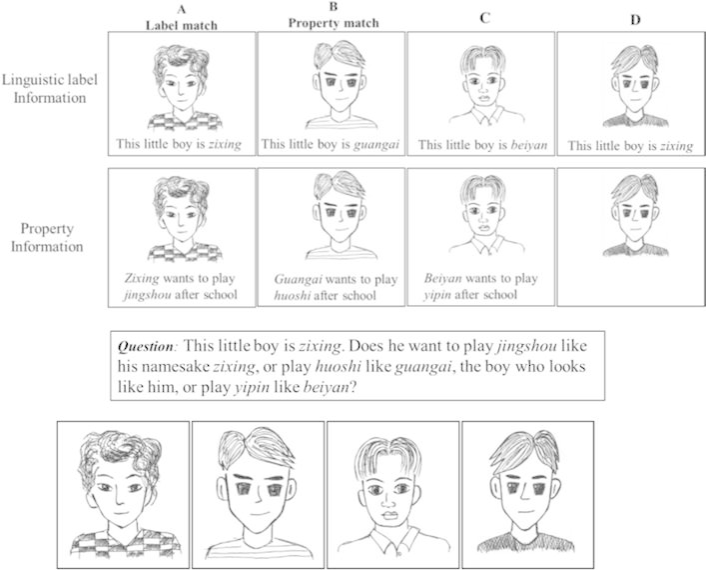

梁渊,闫婕,李艳,肖颖,燕浩* (2025). How Linguistic Labels and Objects Types Shape Inductive Reasoning in Chinese Preschool Children Aged 3 to 5 Years. Infant and Child Development, 34(4), e70033.(SSCI JCR Q2)

注:这是实验给娃出的“认亲选择题”:左边三个小人儿,一个只同名不同貌(标签匹配)、一个只同貌不同名(属性匹配)、还有一个纯属路人(干扰项),娃得回答 “新来的这个人,到底是跟同名的那个玩,还是跟撞脸的那个玩”。这简直是一道精准的 “灵魂拷问”:在孩子的世界里,交朋友到底是“认名字”还是“认脸”?

3-5岁大脑推理系统,正在加载“高级补丁”!“语言标签”是核心插件,但加载效果取决于物品类型:自然物(如人物)能成功安装,让孩子从“刷脸认证”转向“调用内在大数据”;人造物(如玩偶)则兼容性不足,孩子还是主要依赖“外观扫描”。5岁是升级关键期,抽象归类能力大幅解锁,不过对人造物的“算法”还需要更多训练数据!

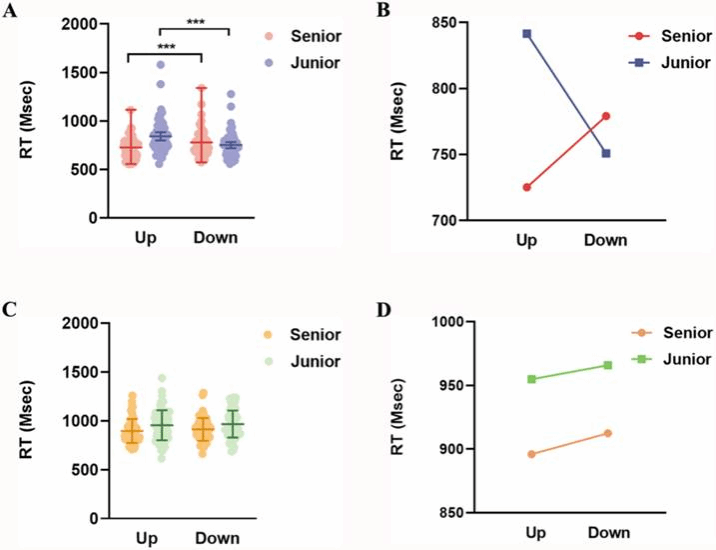

张艺,段绪,冀婷,冯延琴,董秋峰,燕浩*(2025). Conceptual transfer in the mind of Chinese English learners: Spatial metaphorical concepts of kin terms. International Journal of Bilingualism, 13670069251391120.(SSCI JCR Q2)

注:这张图揭示了大脑的“语言滤镜”:说中文时,亲属词自带尊卑坐标轴(长辈在上,晚辈在下);换成英文,这套“空间密码”就失效了——不同语言塑造了不同的认知模式。

研究发现,二语学习者脑子里能装两套“认知系统”。英语学得越好,你的中文亲属词认知越可能被“悄悄改造”。这波“逆向概念迁移”实锤了:你学的语言,真的会偷偷给你大脑“重新布线”!

三、语言习得与教育(Language Acquisition and Education)

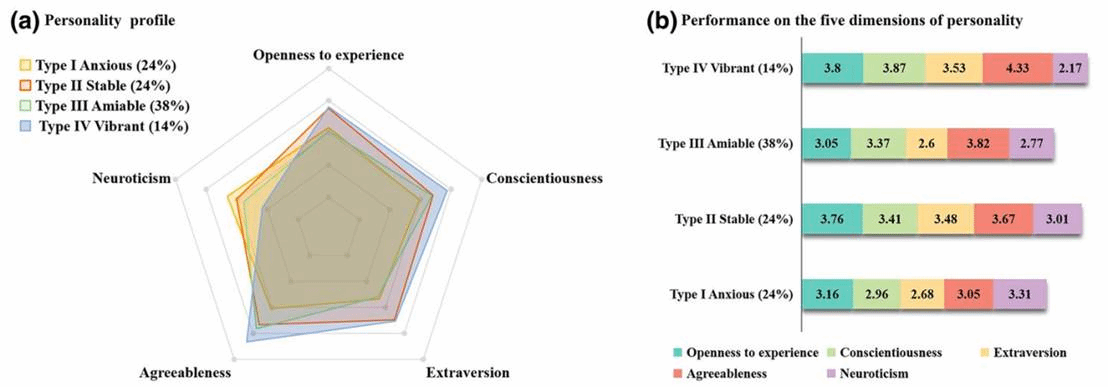

梁渊,冀婷,周淑莹,刘晓琳,燕浩*(2025). Applying the online language learners’ characteristics model in connection with various personality traits: A latent profile analysis. British Educational Research Journal ,00, 1–23.(SSCI JCR Q1)

注:性格决定学习状态,而你属于哪一派,可能早就写在你的“人格使用说明书”里了。

给理工科大学生画个像,看看不同性格(按“大五人格”分类)的人上网学语言有啥特点。在线语言学习特征可以从以下五方面描绘:策略、态度、动机、归因、自我效能感。而学生人格大致分四型:焦虑型、稳定型、随和型、活泼尽责型。猜谁最厉害?活泼尽责型夺冠!他们策略多、动力足、自信心爆棚。研究还顺手给了教学妙招:把活泼的和焦虑的同学组队,就能互相带飞!

四、语音情感识别(Speech Emotion Recognition)

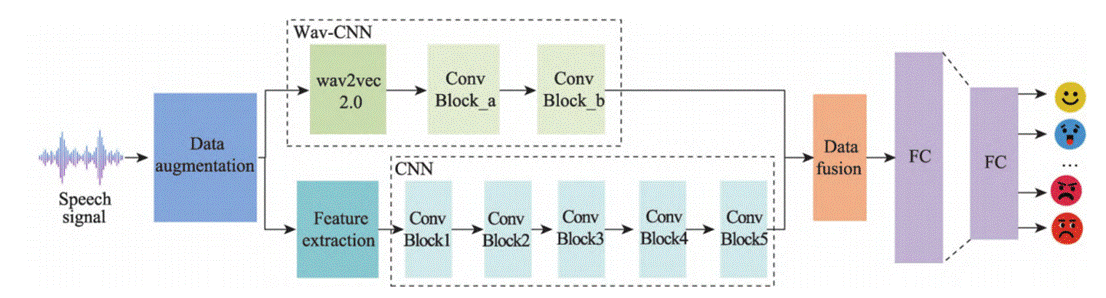

张丽敏, 李扬, 蔡浩,燕浩*(2025). 多层次通道融合语音情感识别方法. 计算机科学与探索, 19(08), 2219-2228.(北大中文核心,CSCD检索)

注:这张图展示了AI的“情感双通道”:左侧进行数据增强;中间两个并行通道分别用Wav2vec 2.0和CNN提取语音数据的深层表征和浅层表征;最后像“情感调音师”一样把深浅特征融合,让AI识别你的真实情绪。

给AI装上“情感耳朵”(语音情感识别系统)!它先用数据增强练就“抗噪听力”(提高模型的鲁棒性),再开双通道:一个深挖语音内涵(wav2vec 2.0),一个捕捉声音表情(CNN),再把语音数据的深浅特征一融合,AI就能准确识别你的真实情绪~